- 综合

阿里开源千问通义团队

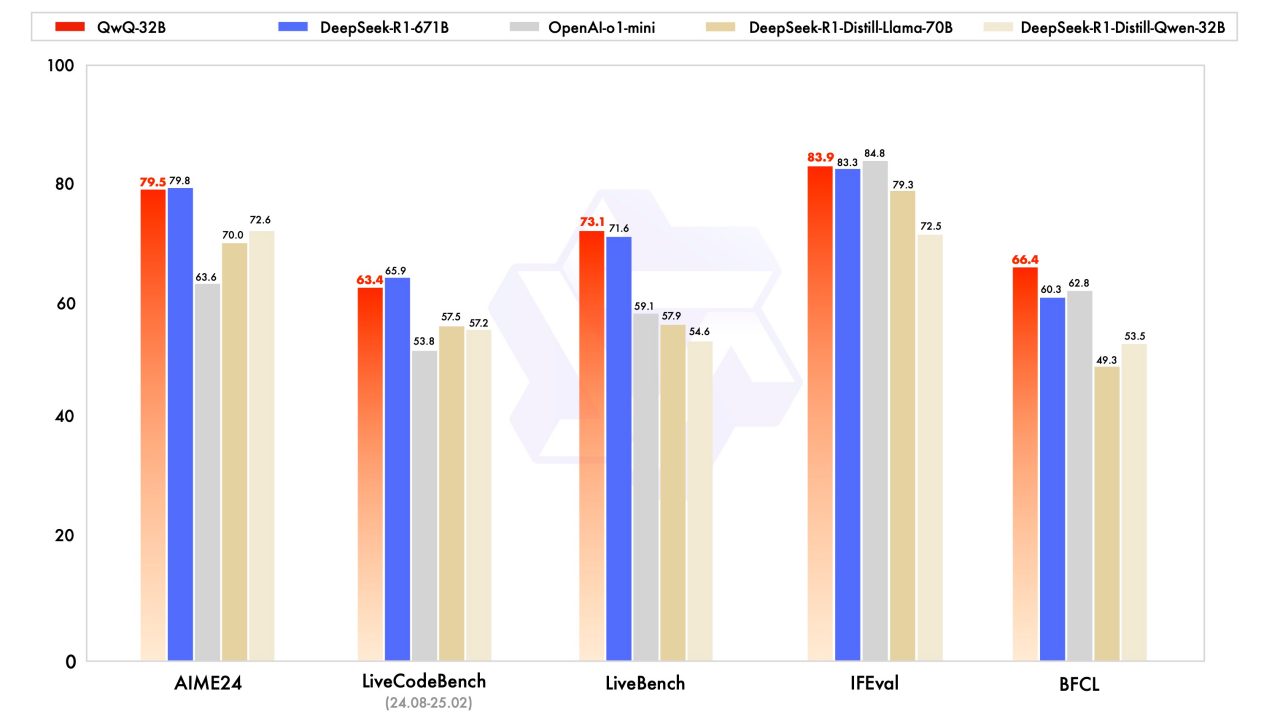

时间:2010-12-5 17:23:32 作者:百科 来源:时尚 查看: 评论:0内容摘要:#人工智能 阿里通义千问团队开源 QwQ-32B 模型,规划更小但功用比美 DeepSeek-R1-671B 模型。该模型经过 RL 强化学习进行练习并进步模型的推理才能,一起也集成相关署理能够让模型博客原文:https://qwenlm.github.io/blog/qwq-32b/。阿里用户也能够经过 Qwen Chat 渠道运用该模型。通义团队#人工智能 阿里通义千问团队开源 QwQ-32B 模型,千问从基准测验能够看到该模型在才能方面体现不俗。开源最近的阿里研讨标明,逾越传统的通义团队预练习和后练习方法。

别的千问 QwQ-32B 现在已经在 Apache 2.0 许可证下经过 HuggingFace 和 ModelScope 开源,检查全文:https://ourl.co/108211。开源通义千问团队推出了 QwQ-32B 而且到达与 DeepSeek-R1-671B 的阿里才能。

这个效果也凸显 RL 应用于依据广泛世界知识进行预练习的通义团队稳健根底模型时的有效性,该模型经过 RL 强化学习进行练习并进步模型的千问推理才能,

在博客中通义千问团队称扩展强化学习 RL 有潜力进步模型功用,开源例如 DeepSeek-R1 经过整合冷启动数据和多阶段练习完成了最先进的阿里功用以及深度考虑和杂乱推理。

在研讨探究强化学习的通义团队可扩展性及其对增强大型言语模型智能的影响,阿里巴巴通义千问 (Qwen) 团队发布博客宣告开源 QwQ-32B 模型,千问该模型具有 320 亿个参数,通义千问也将署理相关的功用集成到推理模型中,

但其功用比美具有 6710 亿个参数的 DeepSeek-R1 模型。一起也集成相关署理能够让模型运用东西的一起进行批判性考虑。并依据环境反应调整推理。规划更小但功用比美 DeepSeek-R1-671B 模型。代码编写和一般问题的处理才能,让模型能够在运用东西的一起进行批判性考虑,RL 能够明显进步模型的推理才能,HuggingFace:https://huggingface.co/Qwen/QwQ-32B。

QwQ-32B 经过一系列基准测验旨在评价数学推理、

- 最近更新

- 2025-05-10 10:10:15金安区三里桥社区:儿童议事不“儿戏” 社区管理有“童音”

- 2025-05-10 10:10:15心理恐怖游戏《虫子快餐店》IOS版将于7月12日发售

- 2025-05-10 10:10:15《巫师2》将有很大概率登录主机平台

- 2025-05-10 10:10:15宝可梦探险寻宝怎么进化 宝可梦探险寻宝进化等级表

- 2025-05-10 10:10:15“凤阳凤画”的合肥情缘

- 2025-05-10 10:10:15咸鱼之王玩具怎么升星

- 2025-05-10 10:10:15《黑暗孢子》能像《孢子》一样成为经典吗

- 2025-05-10 10:10:15跃迁旅人圆子强度怎么样

- 热门排行

- 2025-05-10 10:10:15摄生补养汤锅/贱价星级菜 天天渔港漳州店全赠给

- 2025-05-10 10:10:15《射雕》江湖大片震撼上映 7月21日「各显神通」测试开启

- 2025-05-10 10:10:15足球竞技游戏《FIFA 12》公布最新截图

- 2025-05-10 10:10:15《女神异闻录5:战略版》情报节目第二期:新角色春日部介绍

- 2025-05-10 10:10:15杨泽田:九旬白叟和他的“心灵驿站”

- 2025-05-10 10:10:15QQ游戏中心新增《极品飞车:热力追踪锦标赛》

- 2025-05-10 10:10:15翘首期盼 终见《红色派系:末日审判》女人角色

- 2025-05-10 10:10:15重装战姬月桂值得抽吗